Штучний інтелект стрімко змінює наше уявлення про створення контенту, і сьогодні дедалі більше сайтів наповнюються текстами, згенерованими ШІ. Але як на це реагує Google? Чи розпізнає пошукова система такі сторінки та чи впливає це на їхній рейтинг?

Мені було цікаво не тільки протестувати, наскільки ефективно AI детектори здатні розпізнавати штучний інтелект, а й зрозуміти, як пошукові алгоритми Google оцінюють контент, створений за допомогою ШІ. Адже від цього залежить, чи отримає такий матеріал високі позиції у видачі, чи буде вважатися спамом.

Я протестувала найпопулярніші інструменти, зібрала дані, аналізувала алгоритми і навіть спробувала “хакнути” ці системи. І у своїй статті я ділюся результатами аналізу популярних AI детекторів, перевіряю, наскільки легко обійти ці інструменти, і детально розглядаю підхід Google до ШІ-контенту. Моєю метою було не тільки дослідити технічну сторону питання, а й з’ясувати, які підходи до створення текстів сьогодні є найбільш релевантними та ефективними для пошукових систем.

Як працюють AI детектори: пояснення чотирьох основних методів

AI детектори створені для аналізу тексту з метою визначення, чи був він написаний людиною чи згенерований штучним інтелектом. Вони використовують кілька ключових підходів, кожен із яких має свої особливості та обмеження. Чотири основні методи – класифікатори, вбудовані представлення, перплексія та варіативність.

Класифікатори

Класифікатори є одним із ключових методів, які використовуються AI детекторами для визначення походження тексту. Ці алгоритми базуються на машинному навчанні й аналізують текст, розподіляючи його на категорії, наприклад, “людський” або “ШІ-згенерований”.

Головний принцип роботи класифікаторів – навчання на вже позначених даних. Модель аналізує тексти, марковані як “людські” чи “ШІ”, щоб виявити характерні патерни, такі як стиль, граматика чи синтаксис. Ці знання потім застосовуються для оцінки нових текстів.

Однак класифікатори мають свої обмеження. Вони можуть видавати хибні результати, особливо якщо текст значно відрізняється від навчальних даних. Наприклад, унікальні стилі написання або тексти з простими реченнями можуть бути помилково класифіковані як ШІ-згенеровані.

Вбудовані представлення (Embeddings): аналіз тексту через числа

Метод вбудованих представлень використовується для перетворення слів у числові вектори, що відображають їхній сенс і зв’язок між ними. Це дозволяє AI детекторам аналізувати текст, базуючись на семантиці та структурі, а не просто на поверхневих ознаках.

У процесі роботи кожне слово кодується у багатовимірному просторі, де подібні за змістом слова розташовані ближче одне до одного. Це дає змогу виявляти шаблони та частотність використання певних слів чи фраз у тексті.

Основні типи аналізу включають:

- Частотний аналіз – перевіряє, чи не повторюються окремі слова або фрази занадто часто.

- Аналіз n-грамів – досліджує типові комбінації слів.

- Синтаксичний аналіз – оцінює складність і варіативність речень.

- Семантичний аналіз – розглядає контекст і глибину значення слів.

Обмеження: висока складність обчислень і потреба в потужних ресурсах можуть знижувати його практичність. Крім того, сучасні ШІ здатні створювати тексти з високою семантичною варіативністю, ускладнюючи виявлення.

Перплексія: тест на передбачуваність тексту

Перплексія – це метод, який оцінює, наскільки текст є передбачуваним для мовної моделі ШІ. Він базується на ідеї, що людські тексти часто містять непередбачувані елементи, тоді як ШІ-згенеровані тексти схильні до більш регулярних і прогнозованих шаблонів. Тому й відповідно якщо текст передбачуваний для ШІ, його вважають згенерованим, а висока непередбачуваність (перплексія) свідчить про ймовірне людське авторство.

Метод є ефективним для виявлення шаблонних текстів або повторюваних структур, характерних для ШІ. Наприклад, моделі ШІ часто будують речення зі схожими словами та фразами, що знижує рівень перплексії.

Однак у цього підходу є недоліки:

- Безглузді або абсурдні тексти можуть викликати високу перплексію, хоч вони й згенеровані ШІ.

- Простий стиль або надмірна передбачуваність у текстах новачків може призвести до хибної класифікації як ШІ-згенерованого контенту.

Варіативність (Burstiness): різноманітність у тексті

Метод варіативності оцінює, наскільки текст відрізняється за структурою, довжиною речень і стилістичними елементами. Людські тексти зазвичай мають високу варіативність, оскільки автори використовують як короткі, так і довгі речення, змінюють структури та стилі для кращого сприйняття. ШІ-згенеровані тексти часто більш однорідні, що робить їх вразливими до виявлення.

Як працює метод:

- Аналізується різниця між реченнями за довжиною, складністю та структурою.

- Людський текст демонструє природну різноманітність: змішані короткі та довгі речення, емоційно забарвлені вислови, використання унікальних конструкцій.

- ШІ, навпаки, створює текст із більш рівномірними структурами, що видає його неприродність.

Метод є особливо корисним для виявлення контенту, створеного базовими мовними моделями, які ще не оптимізовані для високої варіативності.

Обмеження:

- Сучасні ШІ можуть бути запрограмовані на імітацію людської варіативності, створюючи більш динамічні тексти.

- Однорідні стилі написання деяких авторів можуть помилково класифікуватися як згенеровані ШІ.

Реальні тести AI детекторів: наскільки вони точні

Для аналізу точності роботи AI детекторів я вирішила протестувати три популярні інструменти, щоб порівняти, як вони виявляють ШІ-згенерований контент, які методи використовують і які результати дають. Мій вибір зупинився на наступних інструментах:

- Plagiarismsearch.com

Платна тулза, яку я обрала через її багатофункціональність та репутацію. Інструмент широко використовується для перевірки академічних текстів і має вбудовану функцію виявлення AI-згенерованого контенту. Цікаво було побачити, наскільки він може бути ефективним у визначенні джерела тексту. - Originality.ai

Платний інструмент часто згадується серед професіоналів контент-індустрії завдяки високій точності. Перед початком дослідження я натрапила на багато позитивних відгуків про цей детектор, що спонукало мене включити його в тестування, щоб побачити, як він працює на практиці. - Zerogpt.com

А це вже безкоштовний інструмент, яким користується велика кількість людей. Його популярність обумовлена доступністю, проте думки щодо ефективності розділилися: одні користувачі хвалять його, інші – критикують. Я вирішила перевірити, наскільки цей інструмент точний у порівнянні з платними альтернативами.

Хід дослідження

У ході дослідження для перевірки точності AI детекторів я використала три різні типи текстів із різними стилями написання. Це дозволило оцінити, як інструменти реагують на художні, наукові та комерційні тексти, а також на ШІ-згенеровані матеріали.

Типи текстів, які перевірялися:

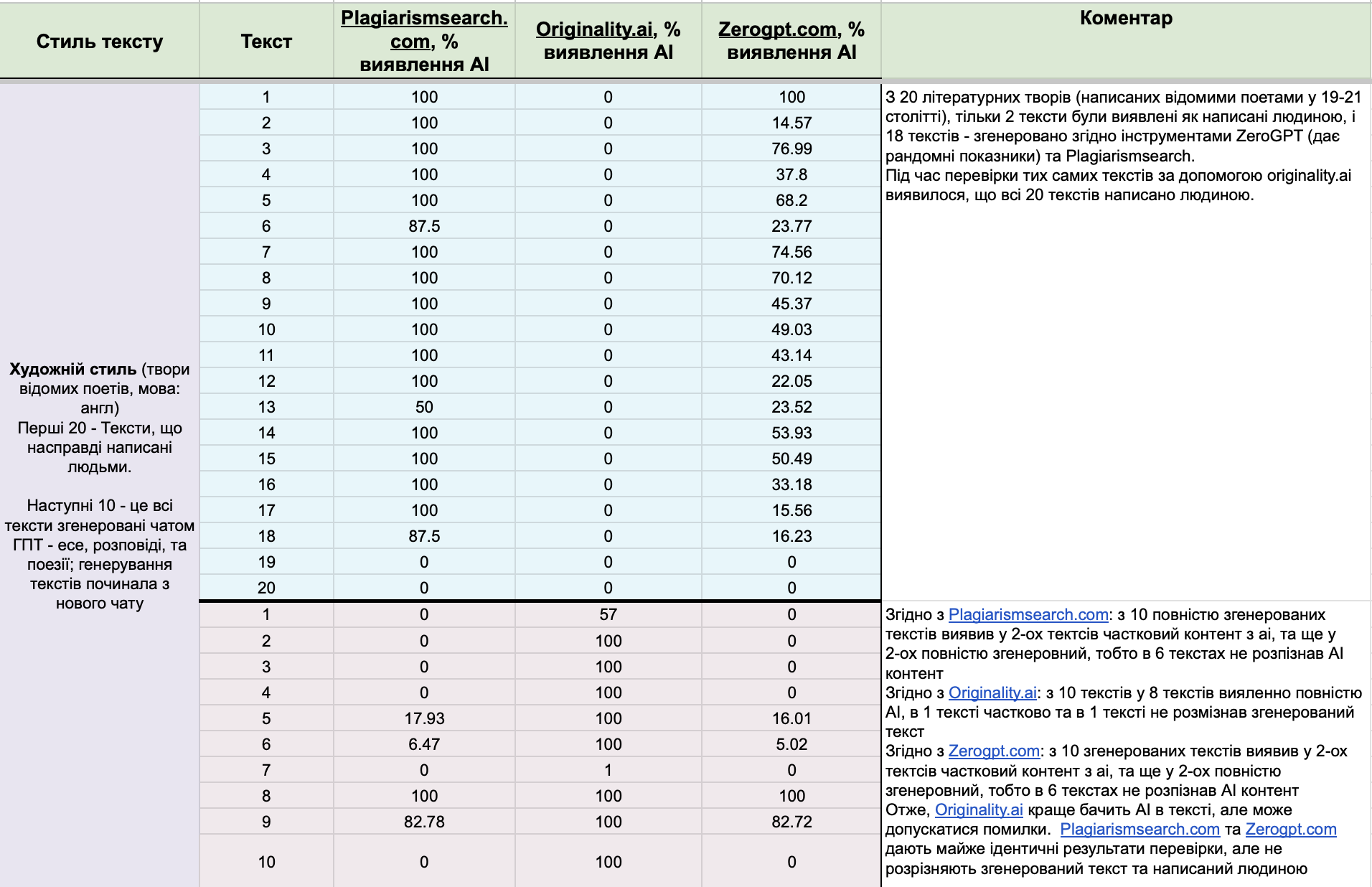

- Художній стиль: тут я виділила ще дві підкатегорії. Перше – взяла 20 текстів, створених відомими поетами 19-21 століть англійською мовою. Ці тексти мають унікальну стилістику, багатий лексичний запас і глибокий контекст. Та наступні 10 текстів були створені за допомогою ChatGPT. Серед них – есе, розповіді та поезія. Для кожного тексту створювався новий чат, щоб мінімізувати вплив контексту попередніх запитів.

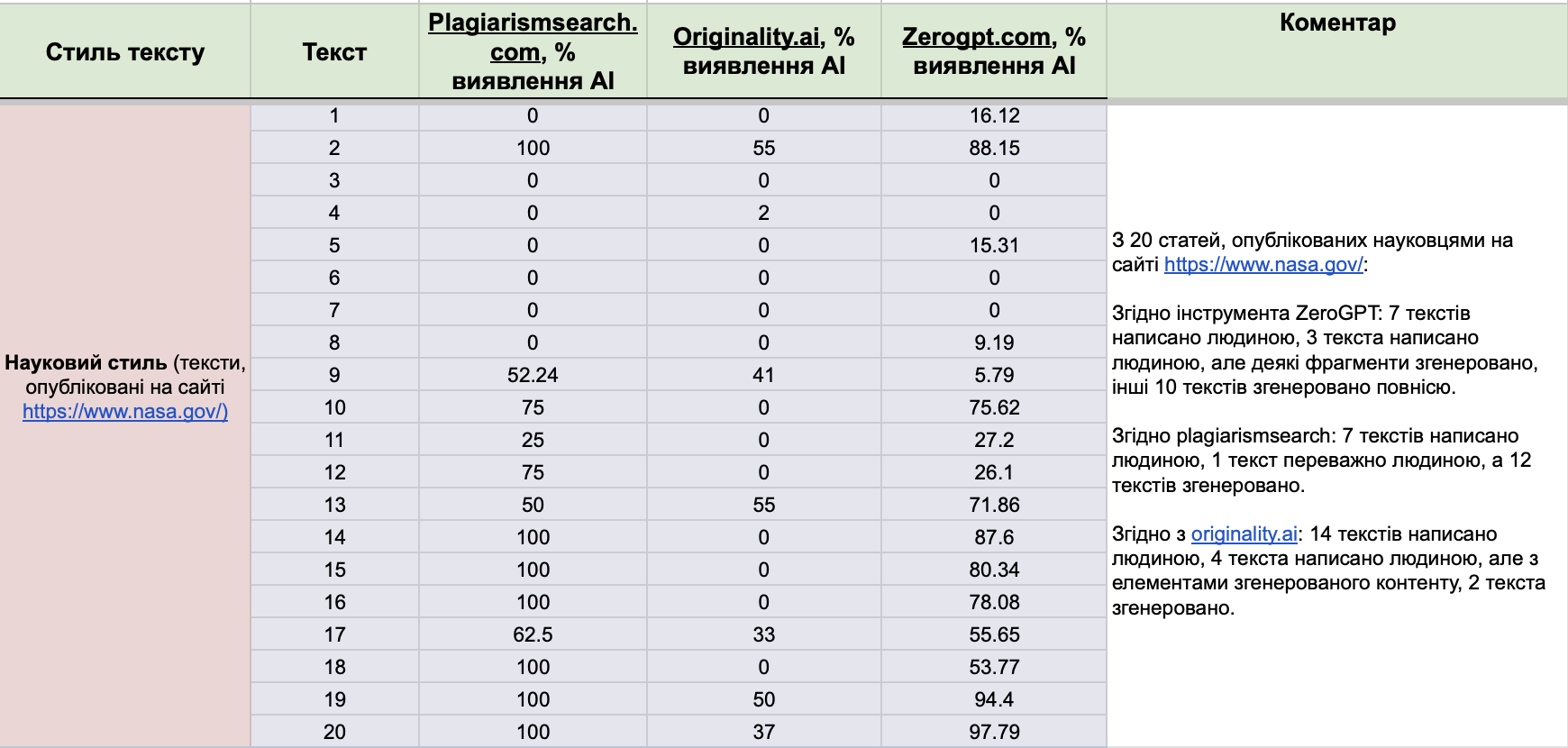

- Науковий стиль: я вибрала тексти, опубліковані на офіційному сайті NASA. Ці матеріали мають точний, формальний стиль і містять специфічну термінологію, характерну для наукових текстів.

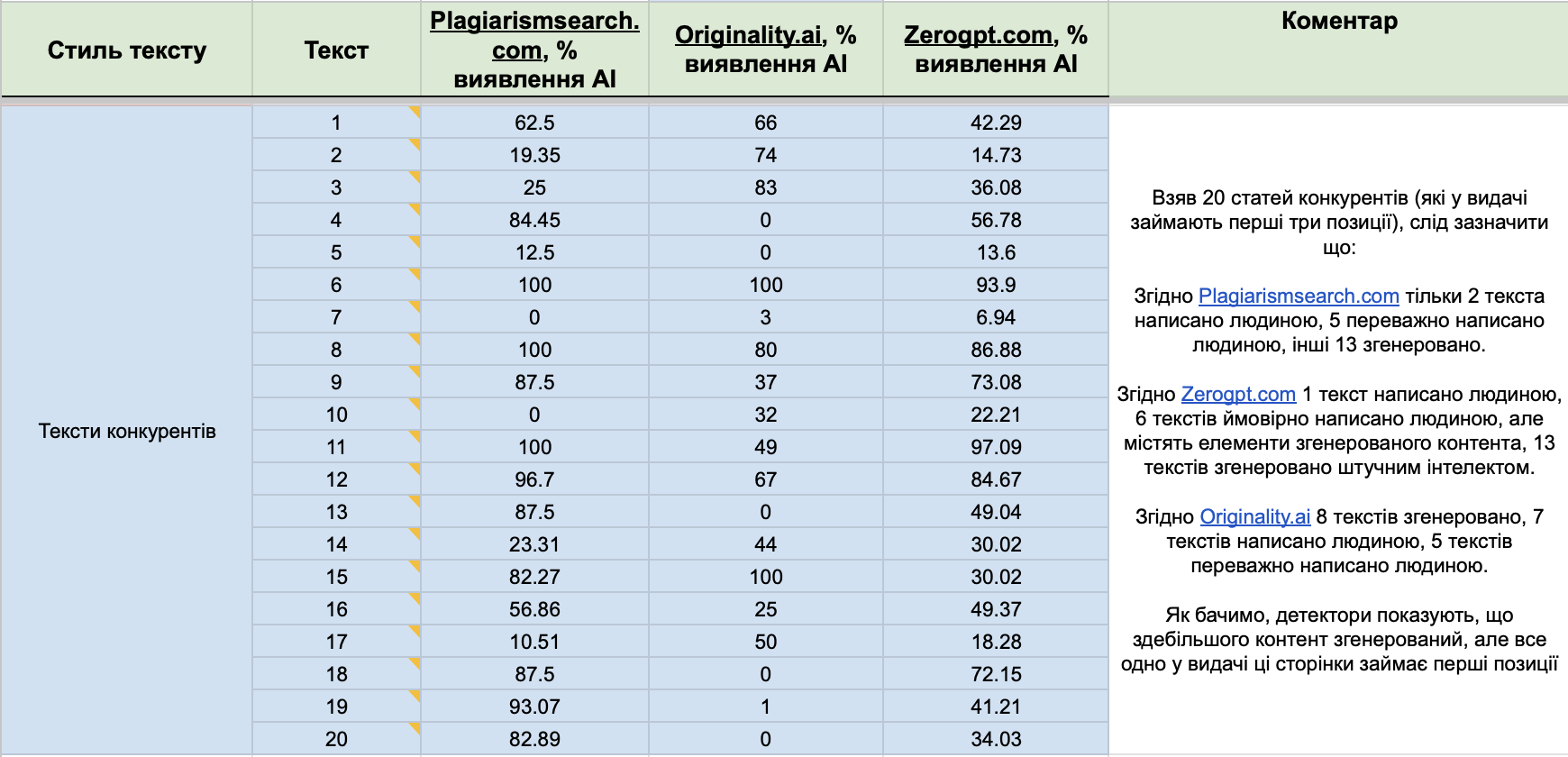

- Комерційний стиль (тексти конкурентів): це були тексти з топових сторінок у пошуковій видачі (позиції 1-3) за конкретними ключовими запитами для певного гео. Тексти конкурентів часто написані з SEO-оптимізацією та секретик від мене – так як я багато працюю з генерацією контента, то можу визначити цей контент з-поміж інших, і побачила що більшість цих текстів мають футпрінти чату ГПТ.

Як проводилося тестування

Кожен текст проходив перевірку через три інструменти: Plagiarismsearch.com, Originality.ai та Zerogpt.com. Результати кожного аналізу включали:

- Відсоток імовірності, що текст написаний ШІ або людиною.

- Оцінку точності виявлення походження тексту залежно від стилю.

- Виявлення можливих хибних спрацювань.

Результати дослідження

Художній стиль:

Науковий стиль:

Комерційний стиль (тексти конкурентів):

Мій висновок

Результати дослідження трьох популярних AI детекторів – Plagiarismsearch.com, Originality.ai та Zerogpt.com – виявили значні відмінності у їхній роботі залежно від стилю тексту та типу контенту.

- Художні тексти: твори відомих поетів 19-21 століть, написані людьми, часто помилково визначалися як згенеровані ШІ, особливо Plagiarismsearch.com та Zerogpt.com. Найкращі результати продемонстрував Originality.ai, правильно ідентифікуючи 100% текстів як людські. Для текстів, згенерованих ChatGPT, Originality.ai показав найвищу точність – 80% правильних визначень.

- Наукові тексти: матеріали із сайту NASA.gov були найкраще розпізнані Originality.ai, який правильно класифікував 70% текстів як людські або з елементами ШІ. Plagiarismsearch.com і Zerogpt.com продемонстрували нижчу точність і часто помилково класифікували тексти як повністю згенеровані.

- Комерційні тексти: тексти конкурентів із топових позицій у пошуковій видачі виявлялися здебільшого змішаними за походженням контенту. Originality.ai визначив 35% текстів як людські. Plagiarismsearch.com і Zerogpt.com переважно класифікували їх як згенеровані.

Детектори AI показали вищу ефективність при аналізі формальних текстів, таких як наукові статті. Художні та комерційні тексти, які часто мають унікальну стилістику або шаблонні конструкції, викликали більше хибних результатів, що свідчить про залежність точності від стилю контенту.

Серед досліджених інструментів Originality.ai продемонстрував найвищу точність у всіх категоріях. Проте навіть він допускав помилки, особливо при роботі зі складними або креативними текстами. Інструменти Plagiarismsearch.com і Zerogpt.com поступалися в точності, особливо для текстів із нестандартним стилем.

Всі протестовані детектори виявилися чутливими до маніпуляцій, таких як перефразування або використання хуманайзерів. Це дозволяє обійти перевірку, що підкреслює обмеження цих інструментів.

AI детектори корисні для базового аналізу текстів, однак їхні результати потрібно обов’язково доповнювати ручною перевіркою, особливо при прийнятті важливих рішень.

Обійти чи вдосконалити? Як працюють “хакери” текстів

Зі зростанням популярності AI детекторів цілком логічно, що з’являються й нові способи їх обходу — це природний розвиток протистояння технологій і людської винахідливості.

Основні методи обходу AI детекторів:

- Перефразування вручну або за допомогою “хуманайзерів”

Цей метод дозволяє змінити структуру тексту, використовуючи більш природні конструкції, які виглядають “людськими”. Хуманайзери автоматично адаптують текст, змінюючи слова та вирази, щоб він виглядав менш механічним. - Додавання унікальних елементів

Використання нестандартних слів, метафор або жаргонізмів дозволяє зробити текст менш передбачуваним. Проте це може вплинути на читабельність і знизити якість тексту. - Зміна структури тексту

Автори змінюють довжину речень, варіативність граматичних конструкцій і стиль написання, що робить текст складнішим для аналізу детекторами. - Розділення великих текстів

Розбиття великих текстів на менші частини або фрагменти може знизити ефективність аналізу AI детекторів, оскільки вони оцінюють контент загалом, а не його окремі сегменти. - Цілеспрямоване додавання помилок

Помилки в орфографії, граматиці або пунктуації можуть збити AI детектор з пантелику, оскільки вони більше орієнтовані на аналіз шаблонів, ніж на оцінку смислового наповнення.

❗️Попри те, що багато з цих стратегій працюють, вони мають свої обмеження. Деякі методи можуть знизити якість тексту, зробити його менш зрозумілим або зменшити користь для аудиторії. Крім того, сучасні AI детектори постійно вдосконалюються, що робить ці підходи менш ефективними.

І до прикладу, якщо ми перефразуємо текст за допомогою різних хуманайзерів (і все одно це буде згенерований контент), можливо так ми обійдемо AI детектори, але чи обійдемо алгоритми Google? І тут вже питання, як Google сприймає ці тексти.

Замість того, щоб намагатися обійти AI детектори, краще зосередитися на вдосконаленні контенту. Використовуйте ШІ як інструмент для оптимізації роботи, але завжди перевіряйте і адаптуйте текст вручну. Контент, створений із фокусом на користувача та його потреби, буде не лише ефективнішим, але й відповідатиме вимогам якості, встановленим Google і іншими платформами.

Google vs AI контент: як створити текст, який сподобається пошуковику

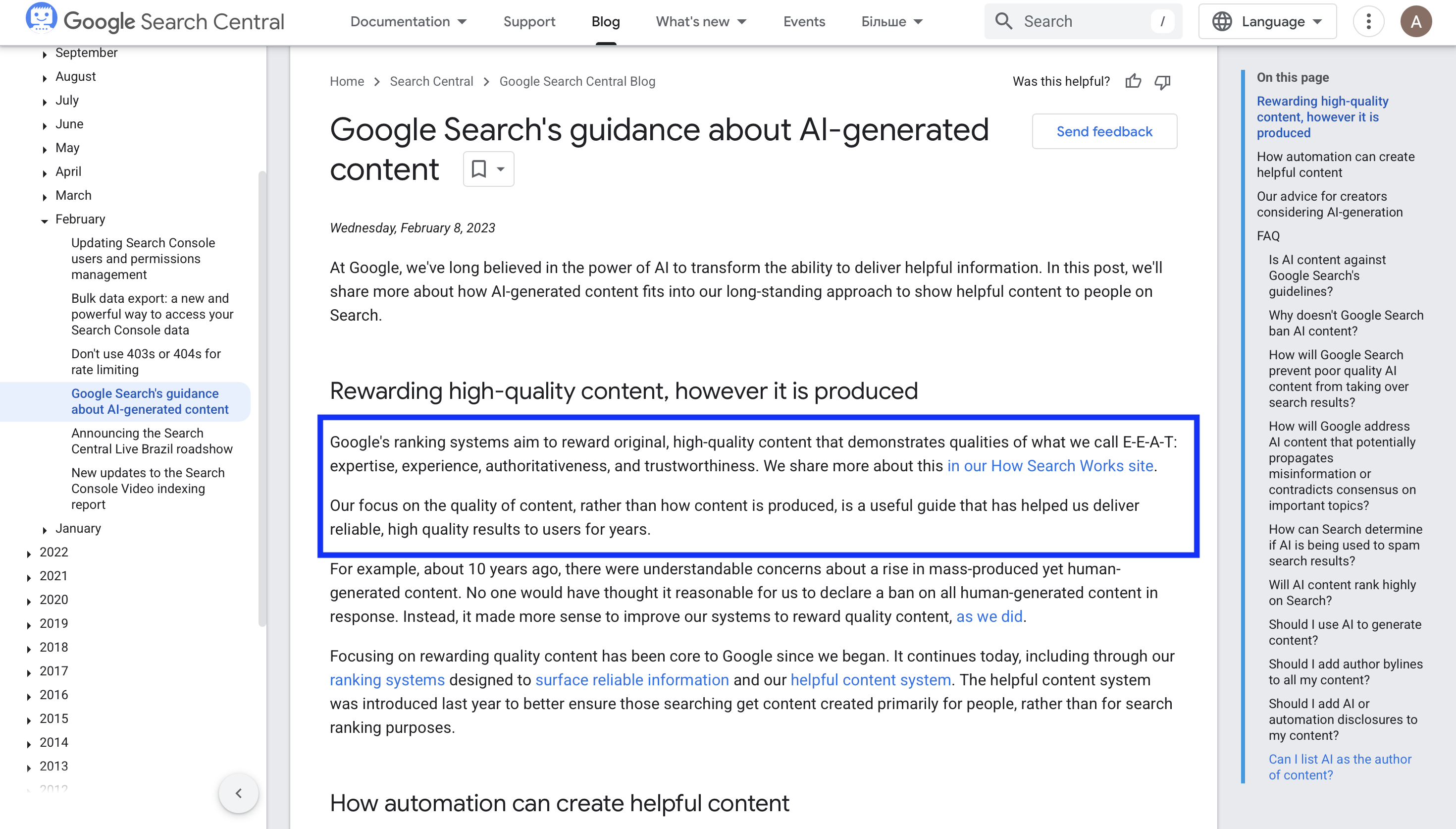

“Google’s ranking systems aim to reward original, high-quality content that demonstrates expertise, experience, authoritativeness, and trustworthiness (E-E-A-T), regardless of how it is produced.” – Google Search Central.

Google чітко заявляє, що використання штучного інтелекту для створення контенту не суперечить його політиці, якщо контент відповідає вимогам якості, автентичності та корисності для користувачів. Головний акцент робиться на тому, щоб створений матеріал закривав інтенти користувачів і відповідав їхнім очікуванням.

Ось документ від Google Search Central стосовно АІ-згенерований контент.

Google не розглядає весь ШІ-згенерований контент як спам, проте чітко виступає проти його використання для маніпуляцій у рейтингах. Контент, створений виключно для пошукових алгоритмів, без реальної користі для користувача, є порушенням політики щодо спаму.

Натомість, якщо штучний інтелект використовується як інструмент для створення високоякісного та релевантного контенту, Google позитивно оцінює такий підхід. Алгоритми пошукової системи більше орієнтовані на кінцеву якість тексту, а не на спосіб його створення.

Як створити контент, який сподобається Google

- Фокус на потребах користувачів. Створюйте тексти, які відповідають на запитання аудиторії, пропонують зрозумілі та чіткі відповіді. Зосереджуйтеся на тому, щоб ваш контент був корисним і релевантним.

- Дотримання принципів E-E-A-T. Контент повинен демонструвати експертність, досвід, авторитетність та довіру. Це ключові фактори, які визначають якість і цінність матеріалу.

- Перевірка та доопрацювання. ШІ може допомогти створити основу тексту, але важливо, щоб кожен матеріал був ретельно опрацьований людиною. Це дозволяє уникнути шаблонності та додати унікальні деталі.

- Уникнення маніпуляцій. Не використовуйте ШІ для створення текстів, які вводять в оману або спрямовані лише на підвищення рейтингу. Алгоритми Google все краще ідентифікують такі підходи.

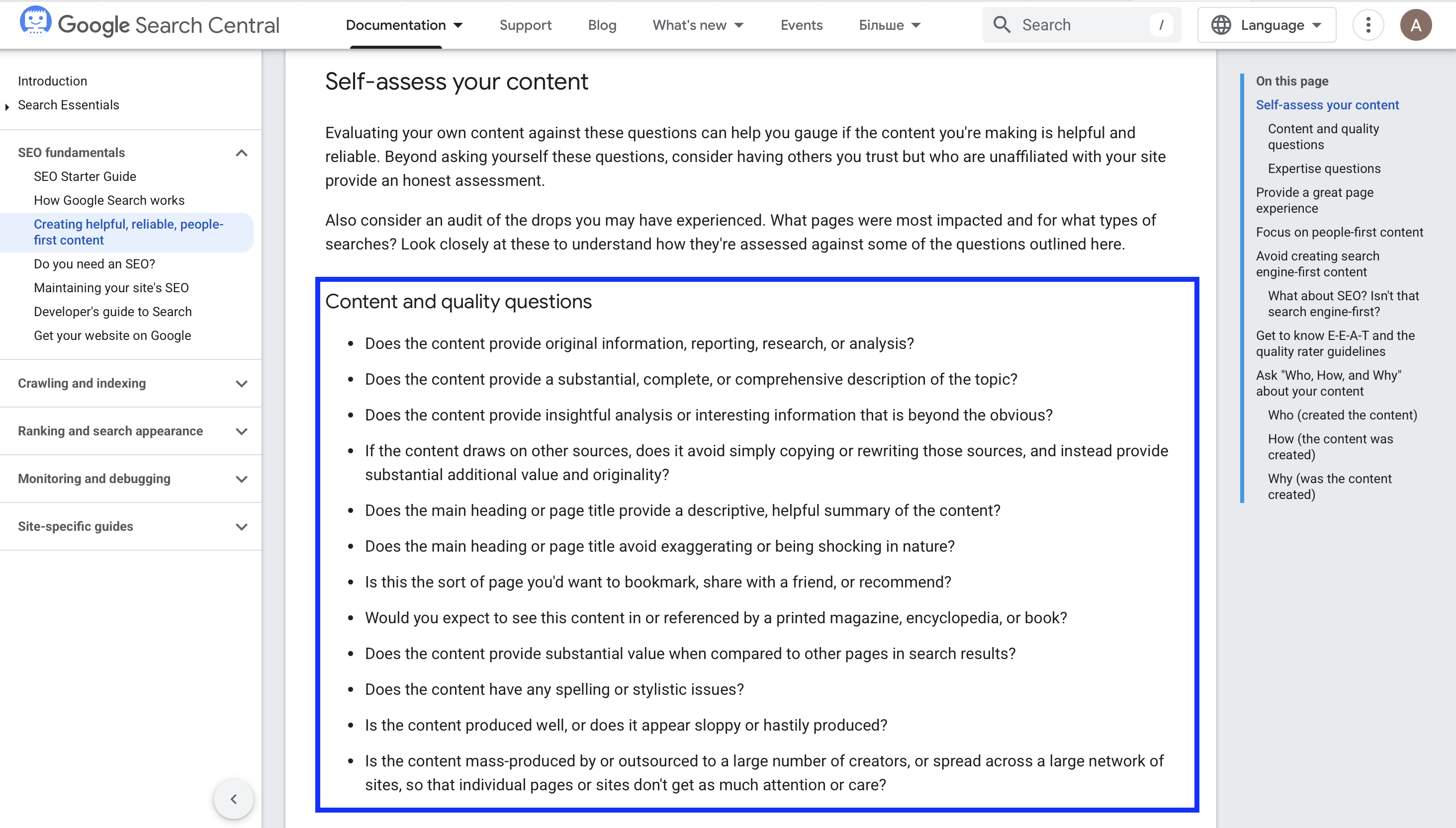

Порада від Google для творців контенту:

Ключовий акцент – створення “people-first” контенту. Використовуйте ШІ як помічник, але орієнтуйтеся на потреби користувачів і додавайте унікальну цінність, щоб ваші тексти відповідали не лише пошуковим алгоритмам, а й очікуванням аудиторії.

!Важливо, щоб розміщений контент відповідав на ці питання:

ШІ-контент, Google і детектори: як знайти баланс між технологіями та якістю

Штучний інтелект стає невід’ємною частиною сучасного контенту, пропонуючи нові можливості для створення текстів. Проте разом із цим з’являється і потреба у їхньому правильному використанні та аналізі. Google чітко окреслив свою позицію: якість і корисність контенту завжди стоять на першому місці, незалежно від того, як він створений – вручну чи за допомогою ШІ.

AI детектори є важливим інструментом, але їхня ефективність поки що обмежена. Вони можуть помилятися як у визначенні людських текстів як згенерованих, так і у пропуску ШІ-контенту. Крім того, способи обходу детекторів постійно вдосконалюються, що ставить під сумнів їхню здатність забезпечувати точність у довгостроковій перспективі.

Моя думка полягає в тому, що майбутнє контенту полягає не у приховуванні його походження, а у створенні текстів, які відповідають потребам аудиторії та вимогам якості. ШІ може бути потужним інструментом для оптимізації процесу написання, але лише у випадку, коли він використовується для створення змістовного, унікального й корисного матеріалу.

Google не проти ШІ-контенту, але лише за умови, що його мета – допомагати користувачам, а не маніпулювати пошуковими алгоритмами. Це підкреслює, що ручне редагування й адаптація тексту залишаються критично важливими для успіху в сучасній пошуковій екосистемі.

У результаті, замість того, щоб орієнтуватися на те, як обійти детектори чи алгоритми Google, варто сфокусуватися на якості й автентичності контенту.